Google Phantom er en af de største Google opdateringer, den har intet navn og er derfor blevet døbt Phantom. Phantom minder på mange områder om Googles Panda-opdatering, men alligevel er den meget anderledes. Begge opdateringer forsøger at belønne sider af høj kvalitet og at straffe sider af lav kvalitet, for at vise de bedste resultater til brugerne. I juni måned i år kørte Phantom for fjerde gang, hvilket i den grad har været noget, der har kunne mærkes for en lang række websites. Nogle som vindere andre som de helt store tabere.

En af årsagerne til at Googles Phantom ikke har fået et officielt navn fra Googles side af, er at der formegentlig er tale om en kerne-algoritme. Den er altså bygget ind i den overordnede algoritme, modsat eksempelvis filtre, som trækkes henover det eksisterende indeks, efter at websites er crawlet, indekseret og sorteret. Google har flere gange omtalt ”Phantom”-kørslerne som kvalitetsopdateringer.

Phantom er kørt 4 gange ind til videre, senest det skete, var i juni måned i år. For hver Phantom kørsel er der foretaget mindre ændringer til algoritmen, det ses tydeligt, hvordan det er forskellige typer af sider, der som udgangspunkt bliver ramt.

Phantom 1 (9 maj 2013)

Den første kvalitetsopdatering, der blev døbt Phantom, kørte tilbage i maj 2013. Scraperwebsites og sider med tyndt indhold var her udsatte og flere websites der tidligere var blevet ramt af Panda (i marts, to måneder forinden), blev også ramt af Phantom. At der så kort tid forinden blev kørt en Panda-opdatering, gjorde det svært at analysere på opdateringen.

Phantom 2 (29 april 2015)

Der gik to et halvt år, før Phantom igen blev kørt. Den anden opdatering i rækken var mere fokuseret på indholdskvalitet og Phantom 2 fik fjernet rigtig mange kategorisider og tag-sider fra Googles indeks, der bidrog med meget lille værdi til de brugere, der landede på dem fra Googles søgeresultater. Phantom 2 så også ud til at gå efter klik-madding/clickbait sider.

Phantom 3: (19 november 2015)

Da Phantom 3 rullede ud i slutningen af 2015, var det primært domæner med brandnavne i sig der mistede synlighed, sammen med opskriftssider og how-to sider. Herudover blev der igen taget vare om de websites, der producerede tyndt indhold og generelt websites af lav kvalitet, i form af både design, tekst og brugeroplevelse.

Phantom 4: (1 juni til 9 juni)

Rigtig mange websites er påvirket af Phantom 4, her er det igen blevet tydeligere at Phantom handler om kvalitet og om at møde brugernes forventning! Tyndt indhold og duplikeret indhold, samt dårlig navigation synes at være et større problem end nogensinde før.

Synes du det er svært at finde relevante linkbuilding-medier? Så prøv Bazoom – en af verdens største handelspladser for linkbuilding. Her finder du relevante medier fra stort set alle lande, opdelt efter sprog, kategori og domæneautoritet. Brug koden Bondtofte1500 og få 1.500 kr. i sign-up bonus (mod normalt 750 kr.).

Indholdsfortegnelse

Panda vs. Phantom

Panda og Phantom minder som sagt meget om hinanden, faktisk virker det som om, at Phantom kigger på mange af de samme ting som Pandaen oprindeligt gjorde. Der har været en lang række Panda-opdateringer efterhånden, den første blev kaldt ”Farmer-opdateringen”, og den blev kørt første gang tilbage i 2011.

Tomme indholdssider, redundante sider og duplikeret indhold, var umiddelbart noget af det, Panda oprindeligt kiggede mest efter. Siden hen har Google dog udtalt, at Panda ikke tager duplikeret indhold med i dens betragtning. Denne udtalelse kom flere år efter den første Panda-opdatering, det er derfor min teori, at flere af de kvalitetspunkter som Panda vurderede på, er taget ud af Panda og lagt over i den nye kvalitetsopdatering, Phantom.

Brugeradfærd den store forskel?

Den helt store forskel på Panda og Phantom syntes at være brugeradfærd. Phantom handler rigtig meget om, at forespørgsler skal mødes af relevante resultater, der møder brugerens forventninger. Det betyder groft sagt, at dit indhold skal passe til den forespørgsel, som dit resultat rangerer på, hvilket selvfølgelig giver rigtig god mening. Denne her forståelse for brugernes intentioner bag forespørgsler, har Google fået igennem opgraderingen til Hummingbird og med introduktionen af RankBrain.

Derfor har arbejdet med søgeord også ændret sig meget. Tidligere arbejdede man meget på, at optimere ud fra søgeord rent kontekstuelt, for at opnå høje placeringer på de specifikke ord. Det Google ønsker i dag, er ikke nødvendiges, at du har forespørgselsmatchende søgeord på dit website. De ønsker i stedet, at du kan svare på den forespørgsel, brugeren har indtastet.

Det betyder også, at når man arbejder med søgeord, er det vigtigt, at man har en forståelse for, hvad brugeren prøver at opnå ved at indtaste en given søgning. Vi skal forstå hensigten, for at kunne møde deres forventninger.

Har du mistet eller vundet trafik?

Hvis du ikke mener, at du har problemer med kvalitet på dit website, kan du overveje om et potentielt tab, kan skyldes at et konkurrerende website, er sluppet ud af deres penalty og dermed er steget i resultaterne. Det kan betyde, at konkurrenten har overtaget flere af dine positioner, og at de nu tager trafik ind, som før gik til dit website. Et fald i synlighed omkring datoerne for Phantom, betyder derfor ikke nødvendigvis, at du er blevet ramt af opdateringen.

Hvis du vil se om dine konkurrenter tidligere er blevet ramt..

kan du se dette ved undersøge søgeordssynlighed i et værktøj som Searchmetrics. Indtast de forskellige konkurrenter og se om de har haft større fald, der harmonerer med datoer for Phantom kørsler. Som nævnt tidligere er det disse datoer, du skal kigge efter:

- Phantom 1: 9 maj 2013

- Phantom 2: 29 april 2015

- Phantom 3: 19 november 2015

- Phantom 4: 1 juni

Et dansk eksempel

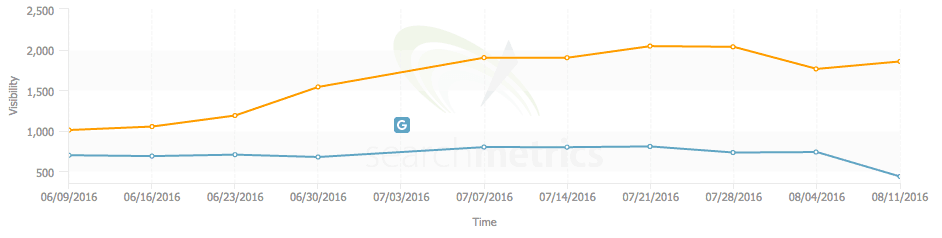

Nedenstående graf viser synligheden, baseret på antallet af trafikgivende søgeord (viste), den øverste graf er en af mine kunder, som blev ramt af Phantom sidste år, og herefter kontaktede mig. Den cyanfarvede graf er en af deres konkurrenter. Det lille blå G indikerer Phantom 4 ifølge Search Metrics, datoen er dog skæv i forhold til alle udmeldinger og egne målinger.

Som det ses, går der lige et par dage fra algoritmen sætter ind, til det begynder at veksle ud. Da Phantom slog ind var min kundes website synlig på 1540 søgeord, mens konkurrenten var synlig på 702 søgeord. Fem dage efter er min kunde nu synlig på 1954 søgeord og konkurrenten er synlig på 437 søgeord. Min kunde steg samtidig voldsomt på deres vigtigste generiske søgeord for den branche de opererer i, mens konkurrenten faldt en del placeringer på selvsamme ord.

Hvilke problematikker tager Phantom sig af?

Ligesom med så mange større opdateringer som for eksempel Panda og Penguin, kigges der ikke kun på nogle få elementer, der måles og vejes på et hav af forskellige parametre.

Alle disse parametre krydskombineres med andre kvalitets- og tekniske vurderinger af websitet, og holdes potentielt set op i mod en vurdering af den samlede linkprofil og populariteten af websitet generelt, målt igennem sociale medier, mentions mv.

I det følgende vil jeg prøve at definere, de parametre, som jeg er overbevist om at Phantom kigger på.

Duplikeret indhold

Phantom ser ikke ud til at være meget for duplikeret indhold, og det har Google i realiteten aldrig brudt sig om. Alligevel har det virket som om, at de er blevet lidt mere lempelige på området, men det ændrede sig igen med introduktionen af Googles Phantom.

Duplikerede sidetitler og meta-beskrivelser er et stort problem, når det kommer til Phantom. Jeg har selv tidligere af flere omgange skrevet og fortalt om Google Panda og duplikeret indhold, hvor jeg også påpegede duplikerede sidetitler og meta-beskrivelser som værende et problem. Jeg er ikke i tvivl om, at Panda har reageret meget negativt på disse parametre tidligere, derfor er det også min teori, at Phantom har overtaget den del af kvalitetsberegningen.

Forkert håndterede mobilsider ser ud til at være et relativt stort problem i forhold til Phantom, og dette skyldes sandsynligvis, at forkerte håndterede versioneringer i realiteten blot er duppletter.

Køres der eksempelvis med et subdomæne der hedder m.domænenavn.dk, hvor der ikke henvises til den primære version med et canonical tag, og lige så ikke fra den primære version til mobilversionen med rel=alternate, så har man en dublet.

Indhold der ikke kan omskrives, betragtes ikke som duplikeret indhold

Google har udtalt, at det for nogle typer af sider, er i orden at køre med duplikeret indhold. Det drejer sig om sider, der for eksempel tilbyder sangtekster fra kendte sange, det kunne også være en side, der citerer lovtekster, altså tekster der ikke bør omskrives af gode grunde.

Hvis man vil forøge sine chancer med den slags sider, er det helt sikkert en fordel for eksempel at tilbyde yderligere information om kunstneren bag sangen, albummet eller anden relevant information, der kan berige siderne og gøre dem mere unikke. Det kunne også være noget så simpelt som at embedde musikvideoen til sangen igennem Youtube. Det er så vigtigt, at man holder indholdet meget relevant, og at man ikke væver. Hvis teksten ikke passer ind og ikke gør indholdet bedre, så er det langt bedre helt at lade være med at tilføje det, ellers risikerer man samme omgang, som mange opskriftssider oplevede ved Phantom 3.

Ikke databerigede kategorier

En kategoriside der rangerer på et generisk søgeord, er som udgangspunkt en ret god indgangsvinkel, til en søger der prøver at blive klogere på et emne, et produkt eller noget helt tredje. Her er det yderst vigtigt, at kategorisiden møder brugerens hensigt med søgningen.

Eksempelvis har jeg en kategori for alle mine linkbuilding-artikler, den rangerer pt. 1 på en søgning på Google for søgningen ”linkbuilding”. På den pågældende kategoriside, har jeg noget introduktionstekst, der kort fortæller om linkbuilding. Her får brugeren altså dækket de indledende spørgsmål, og bliver beriget med relevant viden. I teksten lægges der op til, at man kan læse og lære meget mere, ved at klikke sig ind på en af de mange artikler om emnet. Der bliver opfordret til en handling, teksten er der ikke bare for at have tekst på siden, den er der for at informere brugere og samtidig opfordre dem til at udføre en handling.

Var der ingen introduktionstekst, men blot en liste over indlæg, ville siden på ingen måde leve op til brugerens forventning. Samtidig er Google direkte imod at sende brugere ind på sådan sider. De vil langt hellere sende brugeren direkte ind til det, de leder efter. At sende brugere til en side hvis eneste formål er at sende brugeren til en eller flere andre sider er, som udgangspunkt, et dårligt resultat for Google.

Det er af samme årsag, at Google ikke er meget for prissammenligningssider og affiliate-sider, hvis eneste formål i realiteten er at sende brugere videre. Google vil hellere sende brugeren til sidste destination med det samme.

Brand-søgeord

Det gør sig gældende for rigtig mange websites, der er blevet ramt af Phantom, at de har haft mange placeringer på søgninger, der relaterer til et brand. Især affiliate websites der lukrerer på brand og modelnavne + brandnavn, har mærket en stor nedgang.

Søger en bruger efter et specifikt brand, er chancen for at de søger den officielle side meget stor. Det er derfor du efterhånden sjældent ser en masse websites på brandsøgninger, under det officielle websites. I dag vil et sådan resultat typisk bestå af 7 resultater, frem for de ”normale” 10. Stort set alle, hvis ikke alle, resultater vil være fra den officielle afsender, et site link til websitet og dets undersider, måske et par links til undersider efterfølgende og så links til officielle sociale profiler.

Rich-Snippets

Rich Snippets er udtræk, der vises direkte i søgeresultaterne, data til disse får Google primært igennem struktureret data, men de kan godt finde på at tilføje rich snippets til resultater, der ikke er tagget op. Som udgangspunkt er det dog de sider, der er tagget op, der får vist rich snippets.

Under hver eneste Phantom-kørsel der har været, har der været en stor påvirkning af de involverede siders mulighed for at få fremvist Rich Snippets i søgeresultaterne. Sider der bliver ramt af opdateringen, får ikke lov til at få vist Rich Snippets i søgeresultaterne. Det lader til, at det kun er sider, der vurderes til at være af en vis kvalitet, der kan få vist disse. Kommer et website ud af Phantom igen, aktiveres rich snippets på ny.

Logikken bag kunne meget vel være, at sider der ikke formår at bidrage med kvalitet, ikke bør være for synlige, og at der samtidig er større chance for, at et ikke kvalitetsmæssigt website, prøver at snyde med deres implementering af eksempelvis anmeldelser (Aggregate reviews, schema).

Tekster der ikke møder brugernes hensigt

Nogle af de websites der er blevet hårdest ramt af Phantom-opdateringerne, er som tidligere opskriftssider. En af de ting der gør sig gældende på en lang række af disse sider, er at de har en lang og ikke særlig relevant introduktion for opskriften.

Hvis en bruger søger i Google efter en opskrift, ønsker de sandsynligvis ikke en lang introduktion, der nævner alle søgeord, som måtte være relevante for retten, de søger blot opskriften. Ønsker brugeren blot at få data, bør de præsenteres for denne med det samme, ellers møder man ikke brugerens hensigt, og så er der tale om et dårligt resultat.

Årsagen til at mange tilføjer megen tekst, kan være et forsøg på at gøre indholdet mere unikt. Det er begrænset, hvor meget du kan omskrive en opskrift. Samtidig ved mange godt, at mere tekst med flere søgeord, generelt set kan øge synligheden for en given artikel. Slutteligt er de fleste af den tro, at Google elsker lang tekst.

At Google elsker lang tekst, er en sandhed med modifikationer. Google elsker rigtig nok omfattende og velformuleret indhold, der møder brugernes forventninger. Hvad de til gengæld ikke bryder sig om, er indhold, der udarbejdet til søgemaskiner, og indhold der ikke giver brugerne mere værdi.

Popups

For mange popups, hvad enten det er reklamer, nyhedsbrevstilmeldinger eller noget helt tredje, kan give alvorlige problemer i forhold til Phantom. Årsagen til dette findes sandsynligvis i den dårlige brugeroplevelse, en sådan popup er.

Der er ingen tvivl om, at popups ofte virker. Det er en meget aggressiv form for push markedsføring, men det er på bekostning af dem, som ikke finder budskabet interessant. Hvis du har 3 signups på 100 brugere og dermed en konverteringsrate på 3% og alle brugere er blevet præsenteret for popuppen, har du serveret et irritationsmoment for de resterende 97% brugere.

Kapitalisering af indhold (klikmadding)

En anden faktor der ser ud til at være en trigger, er den måde, man opsætter artikler på. Hvis du tjener penge på sidevisninger (CPM bannere), er det fristende at opdele en artikel i mange bidder. På den måde kan man tvinge brugere til at generere adskillige sidevisninger på en enkelt artikel, der normalt kun ville give en enkelt visning. Rigtig mange aviser og magasiner gør sig brug af denne taktik.

Rent brugermæssigt er denne form for opdeling en belastning. Rent søgemaskinemæssigt deles godt indhold ud over flere URLs i stedet for at det samles på en enkelt stærk og gennembearbejdet side. Udover at skabe en dårlig brugeroplevelse, gør man det også sværere for sig selv, at opnå gode placeringer på langt, velformuleret og relevant indhold.

Opsummering – Få styr på dette for at undgå eller komme ud af Phantom

- Fjern bedrageriske popup annoncer og skjulte annoncer i indhold

- Del ikke indhold der kan stå på en side ud over flere sider (klikmadding)

- Fjern eller omskriv sider der ikke kan matche brugerenes forventninger (sider af lav kvalitet)

- Sørg for ikke at køre med duplikerede sidetitler og meta-beskrivelser

- Undgå duplikeret indhold

- Noindex tag- og kategorisider, der ikke bidrager med nogen værdi (Hvis de blev fundet igennem et søgeresultat)

- Fjern redundant indhold

- Sørg for at især introtekster møder brugernes forventning!

- Fjern paginering, hvor det ikke er nødvendigt

- Fjern reklamer der ligner indhold for meget (klikmadding)

- Giv dine brugere en bedre oplevelse på dit website, ikke kun i form af indhold, men også i form af design og navigation. Brug Analytics til at vurdere dine brugeres oplevelse af dit website.

Vil du kende forskellen på det, Google prædiker – og det, der faktisk rykker i praksis? Bogen skærer igennem guidelines, hype og halve sandheder og viser, hvad der reelt virker i SEO anno 2025. Direkte, konkret og baseret på 20 års erfaring.

God gennemgang og gode råd.

Hvordan skal en shop, der f.eks sælger kondisko adskille sig fra konkurrenterne, når det der primært lægges vægt på er brand, farve og evt størrelse/farcon?

Det er vel lidt samme problemstilling, som ved opskrifter?

Brugeroplevelsen af websitet, er det nemt at finde jeres produkter, får de lige præcis den information de har brug for? Er det nemt at komme videre i et køb. Se eventuelt i Analytics efter sider med mange besøgende, men hvor der ikke kommer salg og hvor afvisningsprocent er høj, det er sider som denne du skal optimere på.

Er det bare mig, eller er billedet med din kundes synlighed helt skævt?

Du angiver, at seneste opdatering af Phantom var fra 1. juni, men på grafen har ser det ud til at du har indsat et G på 1. juli.

Ud fra grafens form, ser det ud til at det ville give mere mening hvis den havde startet en måned tidligere, og at det var 1/6 – 9/6 ændringen skete, og rankings derefter rettede sig op i den efterfølgende måned.

Hej Kim,

Nej, du har helt ret, Searchmetrics har placeret opdateringen forkert :-) Det var i begyndelsen af juni den slog ind, som der også står i selve indlægget. Kunne godt være jeg lige skulle tage et nyt screenshot, uden ikonet, det er misvisende i den grad.

Kategorisider er gode, men sider uden tekst er ikke så gode. Hvordan får man det til at gå op i en højere enhed, eksempelvis på et jobsite for et lokalområde, hvor brugerne klikker sigt fra by-kategorien til de enkelte jobopslag – uden at skrive hovedløse “madopskrifts-intro-tekster” ?

God gennemgang af en stor del af mine kæpheste (DC, redundans i sidetitler etc.). On-site kvalitet bliver bare vigtigere og vigtigere!

Tak Thomas og ja, vi plejer at være enige på de her punkter. Der er mange, der bagatelliserer kritiske områder som duplicate content, selv kendte internationale eksperter.

Har du læst den her Q&A om duplicate content som Eric Enge delte? Hans svar er sådan set fornuftige nok, men prøv at læs resten af svarerene: https://www.ama.org/publications/MarketingNews/Pages/6-seo-expert-answers.aspx

Jeg var så uenig i mange af deres svar, at jeg overvejede at lave et indlæg, hvor jeg modargumenterede.

Super gennemgang – let læselig og let forstålig. Der er aldrig ro på SEO siden. Ever :-)

Hvor mener du grænsen med DC indhold går ved fx meta beskrivelser? Hvis man fx har en sætning omkring kategorien og så en standardsætning med stort udvalg, gratis fragt eller lignende (lad os sige fordelt med 50/50 mellem unikt og standard sætning) og denne går igen på flere sider, er det så DC som man bør være nervøs for?

Jeg er med på at det optimale er 100% forskellige men på store sites er det svært.

Hej Bondtofte

Super god gennemgang og fedt du sætter fokus på at nogle punkter måske stammer fra de gamle Panda opdateringer. Det har helt sikkert skabt forvirring i markedet, når man har skulle finde ud af hvad der har ramt.

Bemærk at nogle folk også rapporterer om datoer i slut juni. Eks. Glenn Gabe:

https://www.gsqi.com/marketing-blog/june-2016-google-algorithm-update/

Fin artikel, men du taler om rich snippets og har også nævnt betydningen af dem i andre sammenhænge, men indenfor min branche “kontaklinser” ses rich snippets ikke? og også andre brancher – er det fordi at Google ruller det ud landevis og ikke er nået til Danmark?

Eller har jeg misforstået noget?

Verdensklasse artikel tak for det. Lidt lang men rigtig indholdsrig. Spot on.

Som jeg forstår det har der netop været endnu en phantom – et godt tidspunkt at vedligeholde artiklen :) Tak for godt indhold

Hej Frede,

Der er umiddelbart ikke sket noget nyt, ift. Phantom, siden jeg lavede artiklen, men du har helt ret, der har lige været endnu et run :-) God arbejdslyst, hvis du er havnet i fælden! Har du brug for hjælp, er det at bare skrive til mig på [email protected]