Google & links – nu og i fremtiden

Hvis du vil have gode placeringer i søgeresultaterne, er links den vigtigste faktor. Arbejdet med at skaffe links kaldes linkbuilding og denne disciplin har ændret sig meget de sidste par år. Arbejdet med links vil ændre sig mindst lige så meget de kommende år. Læs med her og få mine bud på hvordan fremtidens linkbuilding kommer til at fungere i praksis.

[su_note note_color=”#e0e0e0″ text_color=”#005073″ radius=”5″]

[su_icon_text icon=”icon: line-chart” icon_color=”#005073″ icon_size=”18″]

AI-opsummering – skrevet af Henrik Bondtofte, SEO-ekspert med 20 års erfaring. Opdateret juli 2025.

[/su_icon_text]

– Links er stadig vigtigst – men deres betydning er faldende. Google arbejder aktivt på at nedtone linkvægt i algoritmen.

– Co-occurence og co-citation er fremtidens signaler. Google lægger stigende vægt på kontekstuelle nævnelser og tematisk nærhed.

– Mentions uden links tæller mere og mere. Rå URL’er og brandnavne giver autoritet, selv uden klikbare hyperlinks.

– Ankertekster er på vej ud. De bruges stadig – men mere som spam-signal end som rankingfaktor. Risikoen overstiger ofte gevinsten.

– Sociale signaler er svære for Google at bruge – men samarbejde med fx Twitter giver dem adgang. Facebook forbliver lukket.

– Links uden trafik mister værdi. I fremtiden vil kun links, der fører reelle brugere ind, få SEO-værdi.

– Google vil vurdere sider uden links. Test viser at de arbejder på at rangere baseret på brugersignaler og indhold – ikke kun links.

– Total autoritet vinder over deeplinks. Store sites med stærk domain authority outranker selv uden mange direkte links.

[/su_note]

Googles succes er baseret på links

Det der i sin tid gjorde Google bedre end alle andre søgemaskiner, var deres PageRank-algoritme. Algoritmen pålagde enkelte sider en værdi, baseret på hvor mange der linkede til den givne side, samt hvor mange links de sider der linkede selv, havde pegende ind på sig. Med andre ord var det: en matematisk formel der udregner popularitet på sideniveau.

Det betød, at Google udover at kigge på indhold på hjemmesider også kunne give dem en vurdering, ud fra hvor populære de måtte være og hæve placeringerne på de sider, som syntes mere populære end andre. Der blev skabt et hierarki på Internettet, hvor vinderne rent teoretisk, skulle være de mest populære websites, inden for deres respektive brancher og emner.

Her af udsprang ikke overraskende disciplinen linkspam, noget Google har kæmpet med lige siden. De første mange år af Googles levetid, var det i den grad nemt, at manipulere med deres søgeresultater, det hele handlede blot om mængden af links, relevans mv. var mindre vigtigt og indholdet på en side, måtte også vige vejen for mere linktunge sider – uagtet kvaliteten af disse.

Det betød også, at Google i en årrække var sat ind i spam, noget de for øvrigt stadig er, men i langt mindre grad end tidligere. Google er nemlig blevet meget bedre, til at detektere spam og har forbedret den oprindelige PageRank algoritme af flere omgange. Herudover er der kommet mange nye tilføjelser, både i form af helt nye algoritmer, men også omskrivning af selve kernen og introduktionen af en lang række filtre, der trækkes henover det første sæt af resultater, der genereres til søgeresultaterne.

Nemmere at bekæmpe spam end identificere gode links

Google er på ingen måder perfekt. Selvom de altid har været afhængige af linkanalyser, for at generere et godt søgeresultat, har de haft voldsomme problemer med at vurdere kvaliteten af links. Hvornår er et et link tematisk korrekt? Kommer linket fra en troværdig kilde? Er linket redaktionelt eller er det måske købt? Det er bare et par af de ting, Google skal tage højde for i deres udregninger, som danner grundlag for placeringer.

Manipulation vil stort set altid indeholde en eller anden form for mønster. Har man en naturlig linkprofil, vil der ikke på samme måde være et, for en maskine, letgenkendeligt mønster. Her vil linkprofiler til en vis udstrækning differentiere en del. Det betyder også, at det er nemmere at identificere spam og dermed dårlige links. Kan man fjerne sider, der ranker godt på dette grundlag, har man pludselig et renere resultat, også selvom man ikke er blevet bedre til at analysere på links.

Googles løsning på dette var Google Penguin, der blev frigivet tilbage i 2012 – siden Penguin kom til, har linkbuilding ændret sig markant.

Google bliver mindre afhængige af links

Som tidligere nævnt er Googles succes som søgemaskine forankret i deres linkpopularitetsanalyser. Derfor vil Google fortsat være afhængige af links til at vurdere vigtigheden af en given side, men Google har i mange år arbejdet på at blive bedre til at vurdere vigtigheden af sider helt uden brugen af links.

Google har eftersignede også testet deres indeks, hvor de fuldstændigt så bort fra links, men udelukkende vurderede websites på alle andre parametre de måler på. Ikke overraskende, var disse resultater ikke brugbare, dette gav Google selv udtryk for.

Der findes på nuværende tidspunkt allerede to målepunkter, der kan bruges til netop dette og som Google allerede bruger aktivt. Det er mit bud, at Google vil begynde at pålægge disse målepunkter langt højere værdi, mens de gradvist nedjusterer værdien fra rigtige links.

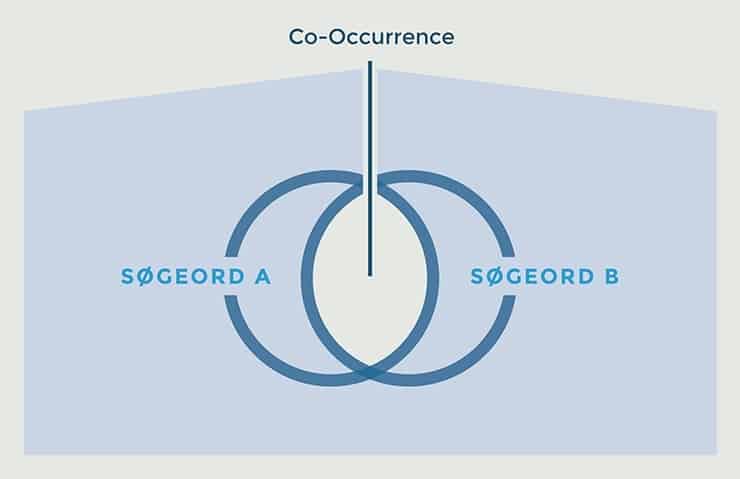

Co-Occurence

Co-occurence er et koncept, der referer til fælles tilstedeværelse, frekvensen af tilstedeværelse, samt nærheden af fælles søgeord, fra et stort udtræk af forskellige websites. Co-occurence kan indeholde søgeord, der er nært beslægtede hinanden og baseret på samme emne, men som ikke nødvendigvis er identiske.

Co-occurence er ikke fuldstændigt linkafhængigt, det betyder også at websites med færre links, kan udrangere sider med flere indgående links, hvis den opfattes mere relevant. Dette kan eksempelvis forekomme, hvis en bruger indtaster samme søgning, to gange, hvor forespørgslen er let omformuleret.

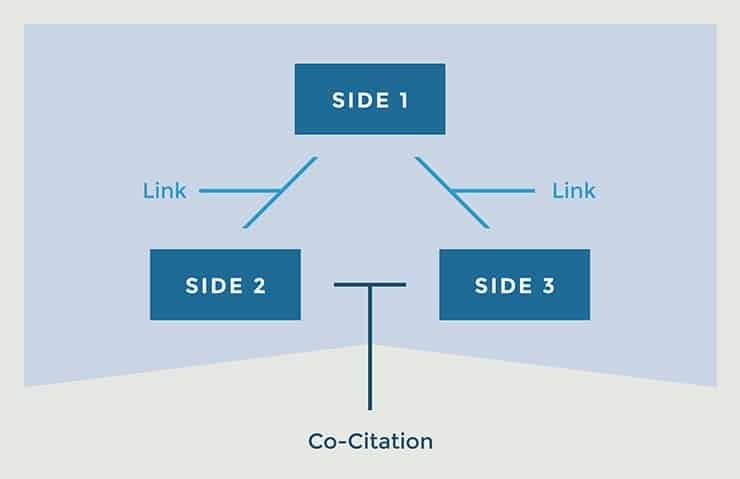

Co-citation

Co-citation finder sted, når et website bliver nævnt, men der ikke nødvendigvis linkes til det og at det bliver nævnt af mindst to forskellige kilder med sammenligneligt indhold. Tanken er, at nu oftere et website nævnes eller henvises til, nu mere stiger websitets autoritet, og der er altså tale om endnu en måde at verificere autoriteten af en given hjemmeside på.

Co-citation bruges på nuværende tidspunkt sandsynligvis også til at spotte fabrikerede linkprofiler, har et website rigtig mange indgående links, men nævnes ikke sammen med andre websites fra samme branche, fremstår det ikke naturligt.

URL-Mentions

Et populært website vil ofte blive nævnt på Internettet, men hver benævnelse vil på ingen måde være med et aktivt link, ofte nævnes sidens URL eller domænets navn blot, uden et aktivt link.

Ikke overraskende, er der ikke mange der arbejder på at skaffe deciderede mentions af deres hjemmesider, da alle gerne vil have et aktivt link. Derfor er jeg også ret overbevist om at Google vil begynde at kigge meget mere på antallet af mentions og prøve at pålægge en højere score til rene mentions, der ikke er formateret som et aktivt hyperlink.

Vi ved ikke på nuværende tidspunkt hvor stor vægt mentions gives, men vi ved, at Google følger mentions, og derfor også forstår, at der rent faktisk er tale om links. For fire år siden kørte jeg et eksperiment med SEO-konsulent Søren Riisager fra Webjuice, der søgte at bevise at Google fulgte URL-mentions og forsøget lykkedes.

Vi har siden dette forsøg, ikke været i tvivl om, at mentions har noget at sige, spørgsmålet er bare hvor meget kontra et normalt link, mit bud er at det nok tæller 5-10% af et rigtigt link, men at denne fordeling vil ændre sig meget i fremtiden og at vigtigheden vil stige markant.

Ankertekster

En ankertekst er den tekst, der er markeret som et aktivt hyperlink. Det kan for eksempel være ’klik her’ eller ’læs mere her’. En ankertekst fortæller desuden søgemaskinerne hvad den side, der linkes til, omhandler. Derfor er de bedste links ofte dem, der er meget beskrivende i ankerteksten, og dem som bruger dit primære søgeord eller indeholder det, som ankertekst.

Søgemaskiner har i den grad brugt dette signal, til at vurdere hvordan en side skal rangere på et specifikt søgeord. Google har været ekstremt afhængige af ankertekster og også i alt for stor grad. Noget de uden tvivl, har arbejdet meget på de sidste par år, ikke mindst ved at introducere Google Penguin, der i den grad, kigger på ankertekster på links, for at vurdere om de er reelle, eller om der er tale om manipulation.

Ankertekster virker stadig og har stadig en ret stor effekt på placeringer i søgeresultaterne, men de er blevet langt farligere at arbejde med. Et godt råd, er at kun 20% af dine indgående links er med stærkt optimerede ankertekster ellers er chancen for en linkstraf stor. Hvis du vil være på den sikre side, bør du allerede nu slå ankertekster ud af hovedet. Jeg er ikke et sekund i tvivl om, at ankertekster helt er på vej ud af Googles algoritme.

Mit bud er at ankertekster er fuldstændigt overflødige for Google i løbet af to til tre år og at de herefter kun bruger ankertekster, til at finde spammere. Spørgsmålet er også, om ankertekster i realiteten ikke allerede er overflødige, da Google er blevet langt bedre til at forstå og bearbejde indhold, derfor er også i stand til at forstå hvad der linkes fra og hvad der linkes til, og om der en sammenhæng, samt hvad de enkelte dokumenter omhandler og dermed hvilke søgeord og søgefraser, indholdet bør rangere højere på, på baggrund af linket.

Sociale anbefalinger og links

Sociale Medier er ikke noget nyt fænomen, men vores brug af dem er eksploderet de sidste par år. Faktisk bruger vi mere tid på de sociale medier end noget andet online. Det betyder også, at mange aktiviteter så som at dele artikler og hjemmesider, man finder interessant, i stor grad er rykket fra hjemmesiderne og diverse fora og ind på de sociale medier. Her deler brugere flittigt, alt det de finder interessant, med venner, bekendte og andre man måtte være forbundet med.

Derfor giver det også rigtig god mening, for Google og andre søgemaskiner, at tælle links og anbefalinger fra sociale medier, som en slags links, for det er jo i bund og grund det samme.

Desværre har Google ikke adgang til de sociale medier på samme måde, som almindelige websites, da det meste foregår i logget ind tilstand. Derfor har søgemaskiner også problemer med at følge med i, hvad der bliver delt og anbefalet. Der er nogle få medier, der tillader adgang, men de helt store medier, gør ikke og har du ikke adgang til data fra de største medier, har du ikke et repræsentativt billede af befolkningen – hvilket betyder, at data ikke er pålidelige.

Ikke pålidelige data, kan naturligvis ikke indarbejdes i en popularitetsalgoritme, der skal diktere placeringer i søgeresultaterne. Derfor bruger Google også i meget lille udstrækning de sociale medier til at finde indhold. Om de overhovedet pålægger nogen værdi til links og anbefalinger på sociale medier, er tvivlsomt. Ifølge Google selv, pålægger de dem ingen værdi.

Men hvad med i fremtiden?

Google vil med allerhøjeste sandsynlighed prøve at lave aftaler med en række sociale medier, for at få bedre og dybere adgang og dermed indsigt i mediernes brugere og deres ageren her på.

Google har allerede en sådan aftale med Twitter, og det er da også derfor, at man så ofte falder over tweets fra Twitter i søgeresultaterne. Google har simpelthen købt sig adgang, til at crawle Twitter igennem – dette ikke mindst for at sikre sig alle de seneste nyheder, Twitter er stadig det medie, hvor det seneste nye, bryder ud først og netop derfor, er Twitter også et umådeligt vigtigt medie for Google.

Den største problematik er og bliver Facebook, Google og Facebook er indædte konkurrenter og det er tvivlsomt om Google nogensinde vil være i stand til at få en ordentlig aftale igennem med Facebook, der gør det muligt for Google at følge ordentligt med. Facebook-boblen er ifølge mange eksperter, allerede sprunget, brugere har efterhånden forstået at Facebook er et medie som så mange andre, en virksomhed, der ønsker overskud til dens aktionærer. Personlige og private-delinger, som var det der gjorde Facebook unikt, sammenlignet med andre sociale medier, er nemlig ved at dø ud.

Hvis Facebook mister mere og mere momentum, er der en åbning på bede for en aftale med Google, hvis Facebook mister deres dominans, kan de have langt større interesse i at indgå en aftale, der gør at langt større dele af Facebook indekseres og dermed bliver muligt at finde i Google. Flere indekserede Facebook-sider vil give en masse søgemaskinetrafik til Facebook.

Dermed mener jeg, at det er et spørgsmål om tid, før de to mastodonter mødes på midten og kommer til enighed omkring en eller anden form for samarbejde. Om det bliver næste år eller om tre år, tør jeg dog ikke forudsige.

Links der giver besøg, vil altid forøge rankings

Fremadrettet vil det være de links, der også medfører besøgende, der vil tælle i linkregnskabet. De links, som man selv kan gå ud og oprette, til højre og venstre, på diverse linksider, linkkataloger, firmakataloger mv. vil holde op med at virke på sigt. Den type links er også det, man kalder for ”acquired links”, netop fordi man går ud og skaffer dem fremfor at gøre sig fortjent til dem.

Det betyder ikke, at du skal holde op med at arbejde med acquired links, for de virker den dag i dag, og de vil fortsat virke i lang tid endnu og virker en taktik, skal den ikke lægges på hylden endnu. Du bør dog være opmærksom på, at dine placeringer ikke vil stå for evigt, hvis du ikke gør dig fortjent til links og helt naturligt modtager links fra andre websites.

Hvis du har brug for inspiration til acquired links, kan du melde dig ind i Linkklubben, hvor du får fire nye linkmuligheder hver eneste måned, så kan du bruge din fokus på at gøre dig fortjent til links i stedet for at bruge tid på at finde linkmuligheder.

Konklusion

Links bliver mindre og mindre vigtige, men er stadig den dag i dag, det vigtigste parameter for gode placeringer, dette billede vil med tiden ændre sig. Ankertekster vil dø helt ud som rankingsignal og vil udelukkende fungere som sladrehank til Google og konkurrenter, lidt ligesom den funktion meta-keywords har i dag, engang var de skælsættende og uhyre vigtige og i dag er de fuldstændigt overflødige, i hvert fald når snakken falder på de store etablerede søgemaskiner, der opererer i Europa.

Vi vil i stigende grad se sider med fantastisk og gennemarbejdet indhold rangere langt højere, og siderne vil sandsynligvis ikke have tusindevis af links pegende ind på sig, men vil servicere brugerne i en sådan grad, at de er langt mere tilfredse med resultatet, end det der leveres den dag i dag. Google vil opnå den funktionalitet, ved hele tiden at forbedre den måde de analyserer brugernes adfærd på og den måde de håndterer det på.

Deeplinks vil få mindre betydning, mens et websites totale autoritet vil få langt mere at sige. Det ses allerede i søgeresultaterne nu, de store og etablerede websites ligger placeret godt på meget konkurrenceprægede søgeord, uden et eneste deeplink, men med masser af autoritet.

Links vil stadig være vigtige i forhold til at få indekseret et website, Googlebot følger links og vil fortsætte med at følge links som små vejskilte, som de altid har gjort, men vil pålægge antallet af skilte en mindre værdi, sammenlignet med kvaliteten af de steder, skiltene peger hen.

Kilder og referencer

- Ahrefs – Link Building for SEO

Praktisk guide til bæredygtig linkbuilding strategi.

ahrefs.com/blog/link-building/

Super godt indlæg Henrik.

Det er altid fedt at høre dine tanker om fremtiden. Det giver i hvert fald kun god mening med at ankertekster kommer til at spille en mindre rolle, og div. mentions spiller en højere rolle.

Mange tak! Glad for, at du kunne bruge det.

Som altid. Velskrevet indlæg.

Men.. Jeg er ikke helt enig i, at links vil få mindre og mindre betydning. Jeg ser det nærmere som, at kvantitet vil få meget mindre betydning, hvor stærke links fra autoritetssider virkelig vil brage igennem.

Det der er super interessant er, om Facebook og Google kan mødes. Jeg tror det ikke. Der er for stor interessekonflikt, da begge lever af betalte reklamer.

Links har allerede mistet en del værdi, over de sidste par år, det vil jeg mene er et uomtvisteligt faktum, men links er stadig den vigtigste enkeltstående faktor og vil være det i lang tid endnu. Det som jeg oplever nu, er at Google begynder at lytte mere til en lang række andre parametre og også en række nye parametre.

Google er for sårbare når de er så afhængige af links og det ved de godt. Nu mere krydstjek, de kan køre ind over en linkprofil og sætte tjektegn ved, nu mere tiltro har de også til websitet. Og den dag i dag, kommer du ikke allevegne kun på gode links, som man gjorde for bare få år siden.

Ift. kvantitet, så syntes jeg også det er det jeg giver udtryk for i indlægget, det er i hvert fald det jeg mener. Rigtige links, der giver besøg og links fra reelle websites, vil alle dage, rykke ved et websites placeringer. Let tilgængelige links, vil få forsvindende lille effekt. Men det er selvfølgelig bare, hvis du spørger mig :-)

Ift. Facebook og Google, så er jeg lidt splittet, jeg kan se fordele og ulemper for begge, jeg tror på at Facebook, for alvor er begyndt at mærke at interessen for mediet svinder ind de næste par år og så tror jeg, at holdninger til en aftale kan ændre sig. Det kan dog sagtens være jeg tager grueligt fejl :-)

Som altid spændende læsning, specielt dine tanker om fremtiden er spændende, det vil gøre seo displinen lidt mere omfattende end den er i dag, og måske nok give mange af de små seo firmaer der har lavet af splog links baghjul – med mindre de tilpasser sig.

Det er altid interessant at høre dine tanker om SEO og Google’s fremtidige udvikling!

Hvis man har prøvet at starte en ny hjemmeside op her indenfor de sidste års tid, hvor man har skrevet noget rigtig godt indhold, vil man tydeligt kunne se at links ikke spiller den samme rolle som de har gjort tidligere. Et eksempel kan være mit projekt med Suplab.dk, hvor vi ranker nr. 17 på “proteinpulver”, med sølle 9 domæner og ét deeplink – alle af middel kvalitet. Det er ikke en placering der giver trafik, men synes stadig det fortæller meget om hvor langt man kan komme med det rigtige indhold.

Mht. co-citations, så er jeg næsten sikker på at disse allerede spiller en stor rolle i dag. For få uger siden oplevede jeg nemlig et massivt ranking boost, bare ved at sidde og hjælpe folk i Amino debatten. Jeg hjalp bare med relevante problemstillinger, og henviste til mit indhold på Riis Media og andre gode hjemmesider, når det var relevant. Som regel uden brug af links, men bare med co-citations eller URL mentions.

Jeg havde også inkluderet mit brandnavn i min signatur, og lur mig om Google ikke har opfattet denne signatur som en slags co-citation, og jeg derfor har fået lidt ekstra troværdighed ud af det. Man skal jo heller ikke glemme at Google anbefaler at man er aktiv på relevante forums i deres retningslinjer.

Hej Mathias, tak for den pæne kommentar og jeg er glad for at høre, du kunne lide indlægget!

Jeg oplever præcis det samme, websites med ikke særligt mange links, kan faktisk klare sig rigtig godt i søgeresultaterne, der er dog ikke nogen tvivl om, at flere gode links, ville gøre det endnu bedre for dem. Det sker efterhånden ret ofte, jeg falder over sider, hvor jeg hurtigt kan vurdere, at placeringen i hvert fald ikke skyldes links.

Co-citations spiller en rolle i dag, så det skal du ikke være usikker på, det kan godt være min formulering har været kringlet, men det er umiddelbart også det jeg prøver at kommunikere i indlægget, altså, at de er aktive og har været det i lang tid, det jeg mener vil ændre sig, er at de vil lytte endnu mere til disse.

Og absolut, Google følger med i så meget de kan og at du er aktiv rundt omkring og snakker om dit fag, smitter af. Hvis du spørger mig, arbejder Google også stadig på AuthorRank, det er nok ikke for sjov at Gary Illye fra Google, siger at det er en dårlige idé, at fjerne rel=Author ;-)

Godt indlæg og tak for mention :-) Min vurdering er at mention har langt højrer værdi end de 5-10% du beskriver. Men er ikke selv gået videre for at teste denne tese og derfor er det selvfølgelig rent gætværk baseret på de seneste års høstet erfaringer.

Tak for et godt indlæg. Det giver stof til eftertanke, og det som nok bliver mere og mere tydeligt for mig, er at der er mange veje til Rom. Googles algoritme er efterhånden så kompleks, at det er rigtigt svært at sige noget med sikkerhed i forhold til ranking, fordi man kan ranke på mange forskellige parametre. Forholdet mellem de forskellige parametre er nok også variabelt.

Fedt indlæg! Kender du til nogen der har lavet pålidelige og up-to-date “no-follow” eksperimenter?

Tak for det Karsten, desværre ikke nyere undersøgelser.

En udvikling der er sket over en hel del år, men helt klart noget man bør have i baghovedet og på To-do-listen, så man ikke sidder uden ideer og fremgangsmåder om et par år.

En enkelt ting herfra:

-Dit Twitter-plugin virker ikke i min ende: [easy-tweet tweet=”Jeg er ikke et sekund i tvivl om, at ankertekster helt er på vej ud af Googles algoritme.” user=”@henrikbondtofte”]

Derudover er jeg meget spændt på at høre mere om URL-mentions i fremtiden. Det er et lidt finurligt koncept, som jeg er meget spændt på om man finder en måde at udføre, uden at “billige-stiletter.dk” ranker hver gang stiletter nævnes. Har du nogle tanker herom? Vil vi skulle vælge vores domænenavne med langt større fokus på brand (Flickr.dk) eller på vores navn, som helt naturligt vil nævnes mange gange (Henrik-Bondtofte.dk).

Og hvad hvis man hedder Simon Hansen og dermed vil have samme navn som 20% (tilfældigt tal) af danskerne?

Super godt indlæg. Der er stof til eftertanke. :)

Super dog artikel om fremtiden. Lige nu er det links men det bliver jo stadig mere stramt og svært.

Hej. Jeg har lige et spørgsmål til det med links. Jeg er medlem af din “linkklub” og får hver måned 4 links mulighed – Fedt! Når jeg har udformet en tekst til et af områderne, skal jeg så lægge links ind til min webshop https://crocca.dk eller er det nok at det skrives ind under oprettelsenprocessen, hvor der spørges til hjemmeside adresse?

Hej Henrik

Jeg er altid fyld med glæde – når jeg for besked om at der er nyt indlæg på din blog.

Det er en fornøjelse at henvise til dine indlæg –

Tak for mange gode indlæg…:)

Hej Henrik. Interessant artikel. Går ud fra den stadig gælder her i 2017. Vi er gået igang med ekstern linkbuilding og har fået nogle links som leverandør kalder kvalitetslink. Et af dem ser jeg nu godt nok på en gratis backlinkchecker er nofollow. Er den så overhovedet noget værd. Uanset dit svar så vil jeg kigge nærmere på miniklub en😀

Hej Finn,

Der er ikke sket det store i forhold til sidste år nej, udover at Google ser lidt forskelligt på links, alt efter branche man befinder sig i. Nofollow-links gør ikke det store for dine placeringer og dog, for uden nofollow-links, fremstår en linkprofil ikke naturlig og det kan holde din vækst tilbage. Det bærende element, skal dog på ingen måder være nofollow-links.