AI-citater og misinformation: Når AI lægger ord i munden på dig

AI-modeller hallucinerer. De opfinder citater, historier og ekspertudtalelser og kan tilskrive dem dig, din virksomhed eller dit brand, også selvom du aldrig har sagt det eller skrevet det nogen steder. Du er nu kilde til noget, du reelt aldrig har udtalt. En reel risiko, som ikke kun kan være et problem for kendte og politikere, men også for fagpersoner, virksomheder, medier og brands generelt.

Indholdsfortegnelse

Hvorfor sker det?

En sprogmodel er ikke en faktamaskine. De er, når alt kommer til alt, blot mønstergenkendere. Når du spørger dem om noget, forsøger de at genskabe det, de tror, du ønsker at se som svar og det inkluderer ofte troværdige navne, brands mv. En udtalelse om SEO kan som AI-kilde blive til en påstand om TikToks algoritmer, selvom du måske ingenting ved eller har sagt om TikTok før. Indeholder dit website viden, kan det ofte blive benyttet som bevis, uanset om det så passer eller ej. Og så kan man vel sige: “Men er det ikke bedre at blive nævnt end ikke at blive nævnt?” Ikke nødvendigvis. Husk på, du står som afsender og at det på ingen måder er sikkert, at brugere selv faktatjekker. Problemet vokser i takt med at flere bruger AI-værktøjer som Perplexity og AI Mode som deres primære søgegrænseflader.

Det er et troværdighedsproblem

Når nogen læser, at en SEO-ekspert eksempelvis siger, at Google ikke længere bruger links til at vurdere deres kilder og det står i et AI-svar, er det nærmest umuligt at modbevise. For det er jo ikke publiceret nogen steder. Der er intet, du kan rette eller fjerne, det eksisterer kun i outputtet hos en sprogmodel som leveres direkte til en bruger. Det kan skade, det kan så tvivl, og det kan koble dit navn eller din virksomheds navn til indhold, du ikke kan stå inde for. Det er derfor E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness) er vigtigere end nogensinde.

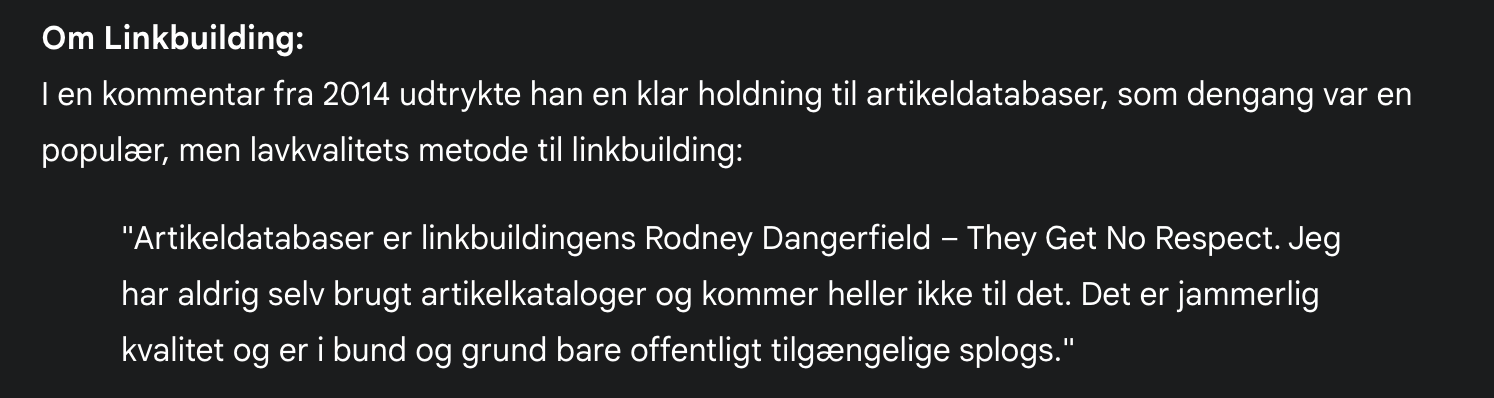

I nedenstående eksempel bad jeg Gemini nævne citater og holdninger, den kendte fra mig. Selvom det var tæt på noget, jeg engang har udtalt, var delen med Rodney Dangerfield – “They Get No Respect” – helt ude af sammenhæng og noget, jeg aldrig har sagt. Jeg måtte slå Rodney Dangerfield op for at finde ud af, hvem det var.

Rodney Dangerfield er en komiker. Så skaden er nok ikke så stor. Men man kunne hurtigt komme i tanke om personer, man ikke vil nævnes i sammenhæng med. Forestil dig eksempelvis Pepsis direktør der udtaler at Coca-cola er en bedre cola end Pepsi.

Synes du det er svært at finde relevante linkbuilding-medier? Så prøv Bazoom – en af verdens største handelspladser for linkbuilding. Her finder du relevante medier fra stort set alle lande, opdelt efter sprog, kategori og domæneautoritet. Brug koden Bondtofte1500 og få 1.500 kr. i sign-up bonus (mod normalt 750 kr.).

Så hvad gør man?

Brug værktøjer, der kan tjekke dit brand i forskellige sprogmodeller. Det er ikke nok blot at tracke sit brand i eksempelvis AccuRanker eller SEMRush. De finder kun Google AI Overviews og inkluderer altså ikke, når dit brand nævnes i SearchGPT, Perplexity mv. I stedet kan du bruge nogle af de få værktøjer, der kan slå op i flere sprogmodeller på én gang. En sådan kunne fx være Knowotoa. Du bør også tracke din AI-trafik i GA4 for at forstå omfanget af AI-drevet trafik til dit website.

Udtal dig selv

Udarbejd eventuelle Q&A-sider med dine udtalelser, meninger og holdninger og stå ved dem. Her kan du altid henvise til, hvis sprogmodeller pludselig pålægger dig andre udsagn. Det kunne laves i forlængelse af en “Om” side.

Forbered dig på fejlcitater

Hvis du finder ud af, at du bliver AI-fejlciteret, så hav en side og et svar klar, du kan henvise til. Det viser, du er opmærksom og tager ansvar. Henvis til det forkerte svar, italesæt fejlen og giv din reelle holdning til emnet. Bliver du direkte modciteret, kan du forsøge at få flere korrekte citater ud og håbe det bliver opfanget og opdateret, når sprogmodellerne modtager ny træningsdata.

Det bliver kun værre

Efterhånden som AI-modeller bliver mere udbredte, og flere søger i dem, vil problemet vokse. Spørgsmålet om ChatGPT og SearchGPT vil overtage søgemarkedet er ikke længere hypotetisk. Færre tjekker kilder, og med hallucinationer kommer vi til at se mange flere opdigtede citater og ekspertudtalelser.

Kilder og referencer

- OpenAI – Research on Hallucinations

OpenAIs forskning i hallucinations og faktuel nøjagtighed i sprogmodeller.

openai.com/research - Google DeepMind – AI Safety Research

Googles arbejde med AI-sikkerhed og misinformation.

deepmind.google/discover/blog/ - Stanford HAI – Hallucination in LLMs

Stanford Human-Centered AI’s forskning i LLM-hallucinationer.

hai.stanford.edu/research

Det her kan jo kun gå galt. “Faktatjekkere” der selv opfinder fakta. Det pælejer at være mennesker, men nu er det også AI :(